Explainable artificial intelligence - Desafios na interpretabilidade de modelos

Video: XAI

Índice da Publicação

Download documento

“A inteligência artificial (AI) é o campo da ciência e da engenharia voltado para a criação de máquinas inteligentes e, principalmente, de software inteligente. Ela está relacionada à tarefa semelhante de usar computadores para entender a inteligência humana, mas a AI não precisa se limitar a métodos biologicamente observáveis“.

Essa foi a definição de AI oferecida por John McCarthy, professor da Universidade de Stanford, um dos fundadores da disciplina e coautor do termo "inteligência artificial".

No entanto, já em 1950, Alan Turing se perguntava: "as máquinas podem pensar?" e formulou o que mais tarde se tornaria conhecido como o "teste de Turing": um teste da capacidade de uma máquina de demonstrar inteligência indistinguível da de um ser humano. Turing propôs que um avaliador humano julgasse as conversas em linguagem natural entre uma pessoa e uma máquina projetada para gerar respostas semelhantes às humanas. Se o avaliador não conseguisse distinguir a máquina do ser humano, a máquina teria passado no teste.

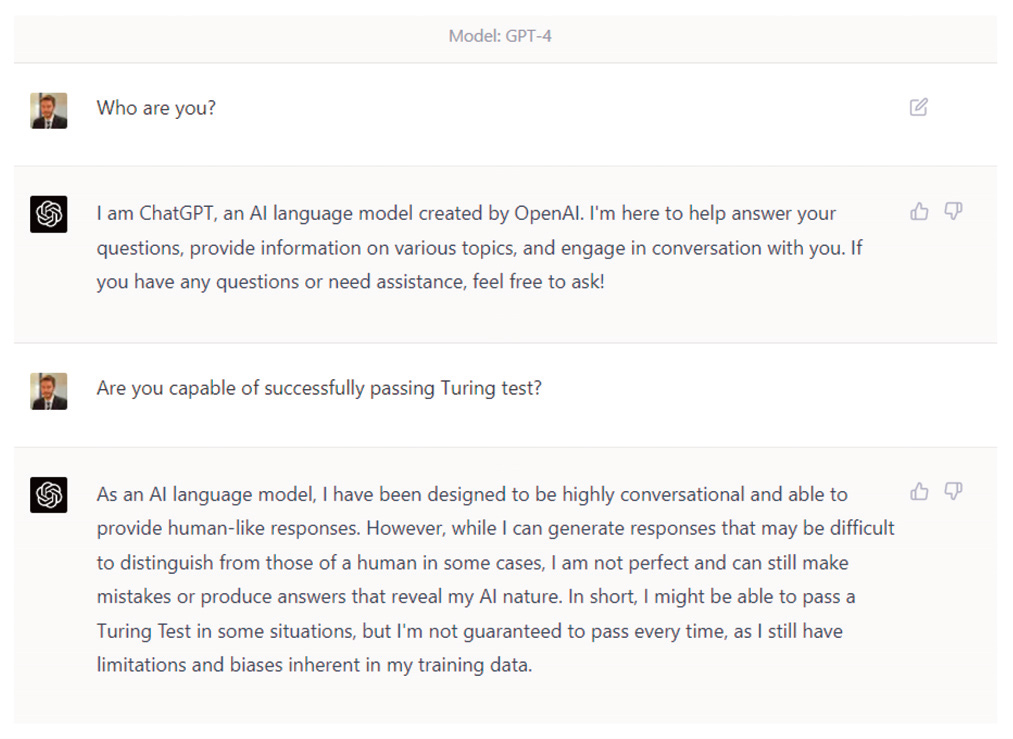

Embora haja controvérsia sobre isso, muitos autores consideram que já existem inteligências artificiais que poderiam passar no teste de Turing, como o GPT-4, da Open AI Foundation, embora o próprio GPT-4 não seja totalmente claro . Há também testes mais sofisticados, como o desafio de esquemas de Winograd, que consiste em resolver anáforas complexas que exigem conhecimento e bom senso, algo que a AI atual ainda não parece ser capaz de fazer.

Conversa com o GPT-4 sobre sua capacidade de passar no teste de Turing

Ainda assim, embora o campo da AI não seja novo, nos últimos anos houve avanços vertiginosos, com aplicações que vão de carros autônomos a diagnósticos médicos, trading automático, reconhecimento facial, gerenciamento de energia, segurança cibernética, robótica e tradução automática, para citar apenas alguns.

Uma característica distintiva da AI atual está precisamente ligada à definição de McCarthy acima: ela não se limita a métodos observáveis e, quando atinge um certo nível de sofisticação, apresenta problemas de interpretabilidade. Em outras palavras: os modelos de AI tendem a ter uma alta taxa de acerto, muito maior do que os algoritmos tradicionais; mas, em cada caso individual, pode ser extremamente complexo explicar por que o modelo produziu um determinado resultado.

Embora existam aplicações de AI em que seja menos relevante poder entender ou explicar por que o algoritmo retornou um determinado valor, em muitos casos isso é essencial e é um requisito regulatório. Por exemplo, na União Europeia, de acordo com o Regulamento Geral de Proteção de Dados (GDPR), os consumidores têm o que é conhecido como “direito a uma explicação”:

[...] não estar sujeito a uma decisão [...] baseada exclusivamente em processamento automatizado [...], como a rejeição automática de uma solicitação de crédito on-line, [...] [na qual] não há intervenção humana envolvida", e tem o direito de "receber uma explicação sobre a decisão tomada [...] e contestar a decisão".

Isso levou ao desenvolvimento da disciplina de Inteligência Artificial Explicável (XAI), que é o campo de estudo que visa tornar os sistemas de AI compreensíveis para os seres humanos, em oposição à noção de "black box", que se refere a algoritmos nos quais somente os resultados são observáveis e o funcionamento do modelo é desconhecido, ou a lógica dos resultados não é explicada.

Um algoritmo pode ser considerado como pertencente à disciplina XAI se seguir três princípios: transparência, interpretabilidade e explicabilidade. A transparência é garantida se os processos que calculam os parâmetros do modelo e produzem os resultados puderem ser descritos e justificados. A interpretabilidade descreve a possibilidade de entender o modelo e apresentar como ele toma decisões de uma forma compreensível para o ser humano. A explicabilidade refere-se à capacidade de decifrar por que uma determinada observação recebeu um valor específico. Na prática, esses três termos estão intimamente ligados e são frequentemente usados de forma intercambiável, na ausência de consenso sobre suas definições precisas.

Para alcançar esses princípios, há basicamente duas abordagens possíveis: desenvolver algoritmos que sejam interpretáveis e explicáveis por sua natureza (como regressões lineares, modelos logísticos ou multinomiais ou certos tipos de redes neurais profundas, entre outros) ou usar técnicas de interpretabilidade como ferramentas para alcançar esses princípios.

Portanto, a XAI se preocupa tanto com técnicas para tentar explicar o comportamento de determinados modelos opacos ("black box") quanto com o design de algoritmos inerentemente interpretáveis ("white box").

A XAI é fundamental para o desenvolvimento da AI e, portanto, para os profissionais que trabalham em contato com ela, devido a pelo menos três fatores:

1) Contribui para gerar confiança na tomada de decisões com base em modelos de AI; sem essa confiança, os usuários desses modelos podem demonstrar resistência à sua adoção.¡

2) É um requisito regulatório em determinadas áreas (por exemplo, proteção de dados, proteção ao consumidor, igualdade de oportunidades na contratação de funcionários, regulação de modelos em bancos).

3) Favorece o aprimoramento e a robustez dos modelos de AI (por exemplo, identificando e eliminando vieses, compreendendo as informações relevantes para produzir um determinado resultado ou antecipando possíveis erros em observações não contempladas na amostra de treinamento do modelo). Isso leva ao desenvolvimento de algoritmos éticos e permite que as organizações concentrem seus esforços na identificação e na garantia da qualidade dos dados que são relevantes para seus processos de tomada de decisão.

Embora o desenvolvimento de sistemas XAI esteja recebendo muita atenção do meio acadêmico, do setor e dos órgãos reguladores, ele ainda apresenta vários desafios.

Este documento analisará o contexto e a justificativa da XAI, incluindo a regulação sobre o assunto e suas implicações na organização; o estado da arte e as principais técnicas da XAI; e o progresso e os desafios não resolvidos da XAI. Por fim, será apresentado um estudo de caso da XAI para ajudar a ilustrar sua aplicação prática..

Índice de conteúdos

Introdução

Resumo executivo

Contexto e fundamentos da XAI

Estudo de caso de interpretabilidade

Conclusão

Glossário

Referências